Published On Dec 7, 2016

Quelques explications supplémentaires concernant la formule présentée à la fin de la vidéo pour calculer rapidement une approximation de P(A|B) (probabilité de A sachant B) dans le cas où B est une preuve de A (au sens où P(B|A) est proche de 1), et où la probabilité a priori de A est faible et nettement plus faible que la probabilité de faux positif. Dans ce cas-là, on a P(A|B) à peu près égal à P(A)/P(B|-A) (c'est-à-dire la probabilité a priori de A divisée par la probabilité de faux positif)

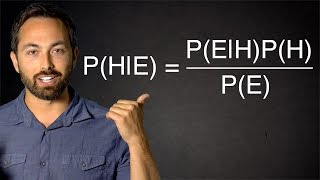

Partons de la formulation complète du théorème de Bayes : P(A|B) = P(B|A)P(A)/P(B)

B se présente comme une preuve de A. Cela signifie que P(B|A) (probabilité de B sachant A) doit être très élevée, c'est-à-dire presque égale à 1 (sinon on verrait mal en quoi B est une preuve de A). Donc, si P(B|A) est à peu près égale à 1, ça signifie que P(B|A)P(A) est presque égal à P(A). Cela permet d'avoir déjà l'approximation suivante : P(A|B) est à peu près égal à P(A)/P(B). C'est déjà plus simple...

Mais comment connaître P(B) ? En fait, on ne connaît jamais directement P(B) ; il faut le calculer de la façon suivante : P(B) = P(B|A)P(A) + P(B|-A)P(-A) (où "-A" signifie que A ne se réalise pas, ce qu'on écrit normalement avec un trait au-dessus de A. Désolé, c'est pas très pratique d'écrire des formules ici...)

Là encore, étant donné que P(B|A) est presque égal à 1, du coup P(B|A)P(A) est à peu près égal à P(A), et donc P(B) est à peu près égal à P(A) + P(B|-A)P(-A).

Maintenant, supposons que P(A) est faible et beaucoup plus faible que P(B|-A). Cela aura pour conséquence que P(A) + P(B|-A)P(-A) est à peu près égal à P(B|-A). (J'avoue que j'ai un peu la flemme d'expliquer en détail pourquoi mais ceux qui ont suivi le raisonnement jusque là ne devraient pas avoir trop de mal à voir. En gros, P(A) va être négligeable par rapport à P(B|-A)P(-A), et P(B|-A)P(-A) sera à peu près égal à P(B|-A).)

Du coup, en effet, sous l'hypothèse que P(B|A) est presque égal à 1 (ce qui est sous-entendu par l'idée que B est une preuve de A) et sous l'hypothèse que P(A) est faible et nettement plus faible que P(B|-A), alors P(A|B) est à peu près égal à P(A)/P(B|-A), c'est-à-dire que la probabilité de A sachant B est à peu près égale à la probabilité a priori de A divisée par la probabilité de faux positif (entendue comme la probabilité que B soit tout de même vrai au cas où A est faux).

Si par exemple vous estimez a priori que A a 1% de chance de se produire et qu'on vous apporte une information B censée prouver A, et que cette information est telle que vous estimez que si A est faux il y a encore 20% de chance pour que B soit vraie (donc probabilité de faux positif = 20%), alors vous pouvez estimez que la probabilité de A sachant cette nouvelle information B est à peu près égale à 1% divisé par 20%, c'est-à-dire multiplié par 5, soit 5%, ce qui reste très peu... (Et notez que l'estimation a généralement tendance à être trop haute.)

Voilà voilà... Avec cette petite méthode en tête, vous éviterez de tomber dans beaucoup de pièges bayesiens !

Et pour aller plus loin, je remets les deux liens que j'avais déjà présentés dans la première vidéo :

En anglais, ce site est très bien et complet : https://arbital.com/p/bayes_rule/?l=1zq

En français, il y a ces très bons articles du blog de Science étonnante de David Louapre : https://sciencetonnante.wordpress.com...

Pour soutenir la chaîne sur Tipeee (financement participatif) :

https://www.tipeee.com/monsieurphi

Pour me suivre sur les réseau sociaux :

/ graindephilo

/ monsieurphi

Le blog : monsieurphi.com