Published On Premiered Jul 2, 2021

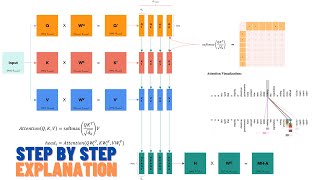

Transformer のモデル構造とその数理を完全に解説しました。このレベルの解説は他にないんじゃないかってくらい話しました。

結局行列と内積しか使ってないんですよ。すごくないですか?

※行列の転値は、「左上に小文字の t 」という文化で生きています。

☆お知らせ☆

AIcia Solid Project 公式HPが出来ました!!!

https://sites.google.com/view/aicia-o...

HPでは私たちや動画コンテンツの紹介、板書データの公開などをしています。是非ご活用ください!!

▼関連動画

忙しい人向けはこちら → • 【深層学習】忙しい人のための Transformer と Multi-He...

Multi-Head Attention は 15:27 から!

Deep Learning の世界 • Deep Learning の世界

自然言語処理シリーズ • 自然言語処理シリーズ

▼目次

公開後追加予定!

▼参考文献

Vaswani, Ashish, et al. "Attention is all you need." arXiv preprint arXiv:1706.03762 (2017).

https://arxiv.org/abs/1706.03762

原論文! やや数式は難解ですが、この動画を見終わった後なら読めるはず!

当時の問題意識や、Transformerの売りどころがたくさん書いてあります。

(個AI的には、論文タイトルは、内容の要約であるべきだよなーと思います。意見や感想じゃなくて。)

【2019年版】自然言語処理の代表的なモデル・アルゴリズム時系列まとめ - Qiita https://qiita.com/LeftLetter/items/14...

いろいろこれを参考にして動画を作っています

▼終わりに

ご視聴ありがとうございました!

面白かったら高評価、チャンネル登録お願いします。

動画の質問、感想などは、コメント欄やTwitterにどうぞ!

お仕事、コラボのご依頼は、TwitterのDMからお願い致します。

動画生成:AIcia Solid (Twitter: / aicia_solid )

動画編集:AIris Solid (妹) (Twitter: / airis_solid )

=======

Logo: TEICAさん ( / t_e_i_c_a )

Model: http://3d.nicovideo.jp/works/td44519

Model by: W01fa さん ( / w01fa )